Os dados sobre paleoclimatologia, doenças como Parkinson, Alzheimer ou transtornos como a esquizofrenia podem ter algo em comum? Um novo estudo, publicado em 26 de agosto na Physical Review Letters, mostra possíveis correlações de análises. A resposta está em um método para quantificar a desordem em dados experimentais e observacionais, que pode ajudar desde a compreensão de mudanças climáticas no passado até a análise de sinais cerebrais. O artigo Quantifying Disorder in Data é assinado por Sergio Roberto Lopes, João Vitor Vieira Flauzino e Thiago Lima Prado, da Universidade Federal do Paraná (UFPR).

A desordem é um tema central em muitas áreas da ciência, mas ainda é um desafio descrevê-la de maneira rigorosa. Conjuntos de informações curtos, comuns em registros de clima, biologia ou medicina, muitas vezes apresentam flutuações difíceis de distinguir, mesmo quando têm origens diferentes, pois são como processos caóticos ou estocásticos. O artigo propõe uma solução: usar a análise de microestados de recorrência.

“Microestados de recorrência são quantificadores de como duas pequenas sequências de números (dois, três, quatro números) se repetem em um dado, numa série temporal, por exemplo. Vários desses pares de sequências são então amostrados. De posse desses pares de sequências, calculam-se as probabilidades de ocorrência de microestados de recorrência. Então o que você tem é um conjunto de probabilidades de microestados de recorrência”, explica Lopes ao Boletim SBF.

Segundo ele, a grande questão é como isso ajuda a diferenciar processos determinísticos e estocásticos. “Esses microestados aparecem em grupos de simetrias. Por exemplo, para um sistema estocástico com distribuição uniforme e sem memória, todos os elementos de cada grupo deverão apresentar probabilidades de ocorrências idênticas. Se isso não ocorre, seu dado não é estocástico e de distribuição uniforme. Um segundo grupo de simetria está relacionado com a reversão temporal. Em geral, sistemas estocásticos com ou sem memória são reversíveis no tempo, ou seja, podem ser analisados de frente para trás ou de trás para frente. Se as probabilidades se alteram nesse processo de análise, seu sistema é então determinístico, visto que nesses sistemas a regra para ir de A até B não é a mesma de ir de B até A. O que fizemos no artigo foi criar um quantificador que mensura essas quebras de simetria. Assim o valor do quantificador traz uma relação com as propriedades do sinal”

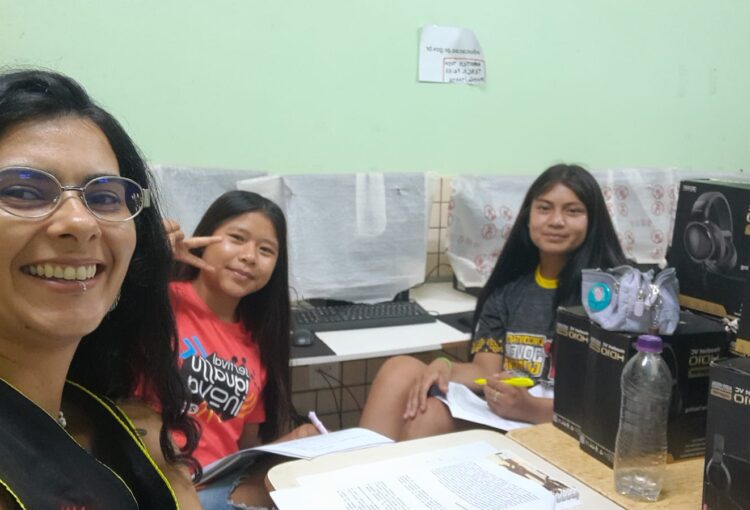

Esse avanço tem uma vantagem prática: funciona mesmo quando a série temporal é curta, como em muitos dados experimentais. “Em geral, dados meteorológicos podem ser curtos, visto a escala temporal em que são coletados (dias ou na melhor das hipóteses horas). Mas podemos utilizar o método em dados biológicos também, onde exames de coleta de informação geralmente são de poucos minutos, gerando assim poucos dados”, explica ele, por e-mail.

Um dos testes apresentados no artigo envolveu registros paleoclimáticos do Cenozoico, período que abrange os últimos 66 milhões de anos. Os mínimos de desordem coincidiram com transições importantes no clima desse intervalo. “O ponto importante nessa detecção das transições do Cenozoico é que podemos inferir sobre a presença de ‘mega-drivers’ na dinâmica, ou seja, um grande influenciador da dinâmica. Por exemplo, um grande vulcão jogando uma quantidade imensa de poeira no ar pode ser um mega-driver no comportamento do clima (local ou mesmo regional ou ainda para derrames colossais de poeira, mundial) nos meses pós-erupção. Partindo dessa possibilidade, podemos conjecturar que o mesmo quantificador pode analisar a estacionariedade de um dado. Detectar essa perda de estacionariedade pode ser uma informação relevante”, explica o físico.

Além da paleoclimatologia, o método pode iluminar outro desafio: o ruído nos sistemas dinâmicos. “O quantificador é muito geral, e em muitas situações a alteração do nível de estocasticidade pode ser relevante. Por exemplo, em dados neuronais, algumas doenças como Parkinson e Alzheimer ou transtornos como a esquizofrenia, o grau de estocasticidade de um exame simples como eletroencefalograma (EEG) pode trazer informações importantes sobre a condição neuronal, embora essas pesquisas ainda não possam ser usadas como pré-diagnósticos. Em um futuro, quando tivermos posse de muitos dados desses (e outros) exames, um processo de classificação pode ser possível, incluindo classificação por IA, baseada somente nesses quantificadores.”

Em termos técnicos, o método mede a entropia da informação sobre os microestados de recorrência. Essa entropia funciona como um quantificador robusto, capaz de distinguir sinais caóticos, estocásticos correlacionados e não correlacionados. Mais do que separar ruído de informação, o processo pode apontar a contaminação crescente em séries de longo prazo. “Não acredito que possamos separar ruído de informação relevante, mas certamente podemos identificar o grau de contaminação e mesmo se esse é crescente em uma determinada medida, por exemplo, uma coleta de dados longa na qual a presença de ruído possa estar aumentando com o passar do tempo.”

Ao fundamentar a medida na simetria dos microestados de recorrência e combiná-la à entropia da informação, o estudo oferece uma nova ferramenta para compreender fenômenos complexos. Dos registros geológicos aos exames clínicos, a espiral de dados que conecta o passado da Terra às incertezas do cérebro humano agora pode ser analisada em busca de padrões de desordem, que podem ser uma chave matemática que atravessa disciplinas.

(Colaborou Roger Marzochi)